Armi. Robot soldato, il «no» degli scienziati italiani

Avvenire

Nuova iniziativa della Campagna per fermare i dispositivi killer: martedì verrà presentato il manifesto degli studiosi che chiede azioni per un divieto preventivo: oltre cento hanno già firmato

Si stanno moltiplicando gli appelli. Forti come grida disperate d’allarme, che si ergono contro lo sviluppo di armi completamente autonome. La “Campaign to stop killer robot” – creata nel 2012 e ormai formata da 93 organizzazioni, tra cui le italiane Rete italiana per il disarmo e l’Unione degli scienziati per il disarmo – è pronta ad alzare il tiro.

Alla voce del mondo pacifista, ha voluto unire quella degli scienziati che li contestano, dal punto di vista tecnico. Martedì, a Roma, nell’ambito della mobilitazione, Rete disarmo, Unione scienziati e Archivio disarmo presenteranno ai media e ai leader politici l’appello di cui si sono fatti promotori, aperto alla firma di altri ricercatori sull’intelligenza artificiale, robotica, informatica e discipline collegate. Vi hanno già aderito un centinaio di scienziati. Con un unico obiettivo: mettere al bando i robot-killer.

Il modello seguito è quello dell’International campaign agaist nuclear weapons (Ican), Nobel per la Pace 2017, che è riuscita a far approvare la Convenzione Onu contro l’atomica. Con un passo ulteriore: stavolta si cerca la proibizione preventiva di sistemi d’arma non ancora impiegati sul terreno. L’appello chiede al governo italiano e al Parlamento di prendere una posizione risoluta contro le armi autonome in tutte le sedi politiche nazionali e internazionali.

A partire dalla prossima riunione della Convenzione sulle armi convenzionali che si terrà a Ginevra dal 25 al 29 marzo 2019. Gran parte dell’opinione pubblica italiana è già favorevole all’iniziativa. Da gennaio 2017 a dicembre 2018, in base a un sondaggio Ipsos, la percentuale dei contrari ai robot- killer è salita dal 54 al 58 per cento, mentre solo il 20 per cento degli intervistati si è detto favorevole. «È un dato che dovrebbe far riflettere anche il nostro governo – sostiene Francesco Vignarca, coordinatore di Rete disarmo –. E, invece, negli ultimi incontri internazionali, il nostro Paese si è mosso solo a ruota di altri e solo per sostenere solo dichiarazioni politiche non vincolanti».

Ventotto governi hanno fatto passi diplomatici significativi per arrivare ad un divieto preventivo delle armi completamente autonome: Austria, Brasile e Cile hanno proposto la negoziazione urgente di «uno strumento giuridicamente vincolante per assicurare un significativo controllo umano sulle funzioni critiche» dei sistemi d’armamento.

Tuttavia, Russia, Israele, Corea del Sud e Stati Uniti si oppongono. Eppure la maggioranza dei cittadini è contraria ai robot-killer anche in Russia (59%) e negli Usa (52%). Mary Wareham, coordinatrice internazionale della Campagna, ha dichiarato: «La finestra di tempo che ancora abbiamo per impedire lo sviluppo di armi completamente autonome si sta chiudendo velocemente». I nostri accademici non sono certo degli sprovveduti, come non lo erano gli oltre mille esperti e ricercatori che il 27 luglio 2014 firmarono la prima lettera aperta sui pericoli dell’impiego in campo bellico delle tecnologie legate all’intelligenza artificiale.

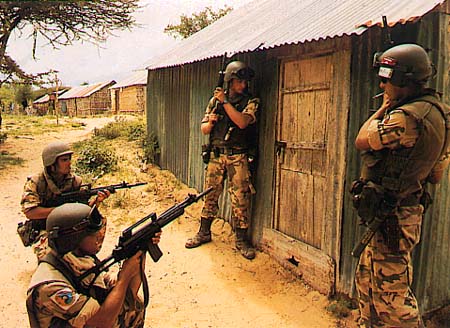

Tutti condividono lo stesso timore, allora come oggi, paventando che le armi autonome possano «divenire i Kalashnikov di domani», banalizzando il ricorso alla violenza armata. Non parliamo di luddisti di professione. Qui non si ripudiano le macchine, ma allerta sui rischi, non solo etici, di delegare in toto alle armi la scelta di come e quando uccidere. I robot killer, però, fanno gola a molti, perché sono più reattivi dell’uomo e trattano più rapidamente le minacce, permettendo di salvare il potenziale militare prima che sia distrutto. Le macchine reggono la fatica, potendo operare con lo stesso livello di prontezza 24 ore su 24, cosa impossibile per un uomo. Possono fronteggiare attacchi massicci e saturanti. E allora? Che dir si voglia, non avranno mai un’etica umana. Il che costituisce una grave minaccia al rispetto dello jus ad bellum (il diritto in guerra), già ampiamente violato negli scenari di conflitto contemporanei. Non è tanto il livello di intelligenza artificiale raggiunto a preoccupare, quanto il grado di autonomia progressivamente concesso alle macchine.

Queste potrebbero compensare gli handicap cognitivi dell’uomo solo in un contesto di profluvio di informazioni. Potrebbero essere utilizzate per compiti ausiliari e specifici, laddove superino gli umani nella capacità di trattamento di una gran mole di dati. Ma concedere loro autonomia di fuoco deve rimanere un tabù, anche se questa modalità fosse impartita da un soldato in scenari specifici, registrata e tracciata in una scatola nera.

Chi potrebbe garantire che il “fuoco automatico” si disattivi autonomamente in caso di difetto ai sensori e agli emettitori? E se i robot fossero piratati? Russi e cinesi non hanno le stesse remore occidentali. Finché la guerra sarà un’attività umana, l’antropocentrismo dei combattenti è un imperativo. L’uomo deve rimanere al centro, come un guerriero centauro alato, a immagine del saggio Chirone e non del focoso e imprudente Nesso. Servono regole d’ingaggio precise da applicare ai robot, prima che l’intelligenza artificiale autonoma dia «alle macchine la possibilità di decidere della vita o della morte di un essere umano».

Questa è una linea moralmente invalicabile. Soprattutto perché i robot- killer pongono un fortissimo rischio di escalation. Siamo sull’orlo di un abisso, di un ulteriore salto nel vuoto nella nebbia della guerra. Una cosa che accrescerebbe la dirompenza distruttiva dei combattimenti, perché i sistemi autonomi ipervelocizzano il ciclo decisionale. Fermiamoli, perché sono solo una trappola tecnocentrica. John Boyd ammoniva già: «Non sono le macchine a fare la guerra. Sono gli uomini che la fanno e vincono, utilizzando solo la loro intelligenza», mista a prudenza.

Fonte: avvenire.it

11 Marzo 2019